Para explicar el desarrollo de la fuerza de la respuesta no todas las soluciones han sido de tipo asociativo, de hecho hay un grupo de psicólogos que han propuesto que la asociación realmente no es la única solución posible (ni quizás la solución) y han propuesto aproximaciones conductuales que son herederas del planteamiento conceptual de Skinner. Skinner propuso que en el condicionamiento operante los reforzadores seleccionan las respuestas, no otorgando un papel necesario a la formación de ningún tipo de asociación concreta, ni E-R, ni E-E. El papel que otorgó a los estímulos ambientales fue el de señalizadores al disponer la oportunidad de que las respuestas se vieran recompensadas, sirviendo los estímulos ambientales antecedentes como moduladores de las relaciones entre las respuestas y los reforzadores (en términos asociativos como moduladores de una asociación respuesta-reforzador), pero no se les otorga ningún papel elicitador como es característico de posiciones más reflexológicas. En la base de esta concepción se encuentra la distinción entre estímulo condicionado, como en el condicionamiento clásico, y estímulo discriminativo, como en el condicionamiento operante.

Teoría de la probabilidad diferencial

Premack señaló que las respuestas que acompañan a los estímulos reforzadores son actividades altamente probables, mientras que las actividades instrumentales son menos probables. La razón de que una respuesta se convierta en reforzadora viene determinada por su probabilidad de ocurrencia en la línea de base: “Dadas dos respuestas en un procedimiento de condicionamiento instrumental, la respuesta más probable reforzará a la menos probable y la respuesta menos probable no reforzará a la más probable”

El principio del reforzamiento de Premack puede considerarse un desarrollo de la idea de que los reforzadores no tienen características intrínsecas en sí mismos sino que derivan su efecto de las disposiciones experimentales en forma de relaciones de contingencia y que cualquier evento, sea un estímulo o una respuesta, potencialmente puede convertirse en un reforzador eficaz. El principio de

Premack tiene dos supuestos fundamentales para que una actividad pueda convertirse en un reforzador:

- Primero, dicha actividad debe ser preferida en la línea de base

- Y segundo, la probabilidad de ocurrencia de la actividad preferida debe restringirse y ocurrir de forma contingente con la realización de una actividad menos preferida, fruto de lo cual la actividad menos preferida se convierte en instrumental.

Como resultado de la operación de reforzamiento, la actividad reforzadora ocurre a menor probabilidad que en condiciones de libre acceso y la actividad instrumental aumenta su probabilidad de ocurrencia (que es lo que ocurre en los experimentos de CO). En una situación típica, animales que tienen un cierto nivel de hambre deben accionar un operando de respuesta para conseguir una pequeña cantidad de comida. En condiciones de acceso ilimitado a la comida y de disponibilidad continuada del manipulando, los animales que tienen hambre dedicarán la mayor parte del tiempo a comer y muy de vez en cuando pueden presionar una palanca o picar una tecla iluminada. Para que la operación de reforzamiento pueda tener lugar, hay que restringir el acceso a la comida y hacerlo contingente con la emisión de la respuesta instrumental (la de menor probabilidad de ocurrencia en la línea de base), que en consecuencia aumentará su frecuencia de aparición o su probabilidad de ocurrencia. De lo anterior también se concluye que las actividades con una menor probabilidad de ocurrencia en las situaciones de libre acceso nunca podrán reforzar a las actividades con una mayor probabilidad de ocurrencia.

Premack y sus colaboradores llevaron a cabo muchos experimentos para comprobar su teoría. En uno de los experimentos, Premack alteró las probabilidades de las respuestas cambiando las condiciones de privación. En un estudio, las ratas fueron privadas de agua, pero no de la oportunidad de correr por una rueda de actividad. En esas circunstancias beber era más probable que correr, y la oportunidad de beber pudo reforzar el correr por la rueda. En un segundo estudio, las ratas no fueron privadas de agua, y así, en esas circunstancias, correr era más probable que beber. Correr podía utilizarse para reforzar la bebida. Así pues, correr y beber podían usarse indistintamente como respuestas reforzadoras e instrumentales, dependiendo del estado de privación de agua del animal.

Premack complementó el principio del reforzamiento con otro paralelo sobre el castigo. En esta ocasión, Premack argumentó que la actividad de más baja probabilidad puede castigar a la de mayor probabilidad siempre y cuando se aumente su probabilidad de ocurrencia y suceda contingentemente con la actividad más preferida, que como resultado de dicha operación disminuirá su frecuencia de aparición en relación con su ocurrencia en la línea de base. De aquí también se desprende que las actividades más preferidas nunca podrán castigar a las actividades menos preferidas.

La posición de Premarck es plenamente conductual y se deriva de la tradición skinneriana cuyo eje central es la ley empírica del efecto. Esta concepción siempre estará limitada por no saber la razón última de por qué los sujetos prefieren una actividad más que otra en la prueba de libre elección.

La teoría de la probabilidad diferencial es simple a la vez que compleja. Por un lado es simple y tiene un gran poder predictivo. Para predecir si una conducta reforzará a otra, simplemente basta con medir sus probabilidades bajo una condición de línea de base, donde las dos conductas estén libremente disponibles en ausencia de limitación alguna. Evaluadas después en un programa de reforzamiento, una actividad reforzará a la otra si, y solo si, ésta era más probable que la otra en la situación de línea de base. No importa si la conducta provoca placer, reduce una necesidad, provoca una activación fisiológica, o simplemente es característica de la especie, lo único importante es que sea más probable que la otra conducta en condiciones de libre acceso.

Por otro lado, es compleja en cuanto a la medida de la probabilidad de la respuesta. Una posible medida es la frecuencia con la que ocurre dicha respuesta. Esa medida es buena siempre que comparemos respuestas parecidas, por ejemplo las presiones a dos palancas, pero ¿cómo comparar las frecuencias de actividades tan distintas como hacer un crucigrama o comer? ¿cuál es la unidad conductual, dar un bocado o tomarse la ración entera?.... Para solventar este problema, Premack sugirió que la probabilidad de la respuesta debía de considerarse en una dimensión temporal, de forma tal que pudiera definirse como el tiempo dedicado a una actividad particular sobre el tiempo total. El periodo de observación en la línea de base es, por consiguiente, crucial para valorar la probabilidad de las respuestas que ocurran sólo periódicamente.Por ejemplo, aunque en un día dedicamos mucho tiempo a comer, la actividad de comer no se distribuye uniformemente a lo largo del día. Es altamente probable a unas horas determinadas. Dado que las probabilidades de las respuestas varían con el tiempo, Premack sugirió que la medida de la respuesta más apropiada es la probabilidad momentánea.

Teoría de la privación de respuesta

En la mayoría de los procedimientos de condicionamiento operante, la probabilidad momentánea de la respuesta reforzadora se mantiene a un nivel alto. Esto se consigue restringiendo la oportunidad de realizar la respuesta reforzadora. Es decir, la respuesta reforzadora tiene que ser más probable que la instrumental y estar restringida. Premack formuló el reforzamiento en función de las probabilidades relativas de las respuestas instrumentales y reforzadoras. Sin embargo, el propio Premack se dio cuenta de que no basta con la probabilidad diferencial, la eficacia del reforzador depende de que estén limitadas las posibilidades de ejecutar esa respuesta.

Eisenberger, Karpman y Trattner propusieron una hipótesis más radical, consistente en que los programas de reforzamiento incrementarán la frecuencia de ocurrencia de la respuesta operante por encima de su línea de base si, y sólo si, dichos programas privan al individuo de realizar la respuesta reforzadora.

La direccionalidad en el principio del reforzamiento propuesta por Premack es cuestionada por la hipótesis de privación de respuesta. Según esta propuesta, para que una actividad pueda funcionar como un reforzador eficaz sólo es necesario restringir la realización de dicha actividad en relación con su ocurrencia en el punto de bienestar (o línea de base con acceso ilimitado a todas las actividades), pero no es necesario que dicha actividad tenga que ser más preferida que la que se va a convertir en actividad instrumental.Esta hipótesis es todavía más relativa que la de Premack sobre el concepto de reforzador, y de hecho en su formulación elude referirse a algo así como el reforzador para poder explicar el proceso de condicionamiento. Puede esquematizarse así: I/R > Oi/Or, siendo:

I = Respuesta Instrumental

R = Respuesta Reforzadora

Oi = Conducta Observada en la línea de base (la que luego será instrumental)

Or = Conducta Observada en la línea de base (la que luego será reforzadora)

Refleja que la proporción entre una actividad instrumental y una reforzadora debe ser mayor que la proporción observada entre estas dos actividades en el punto de bienestar.

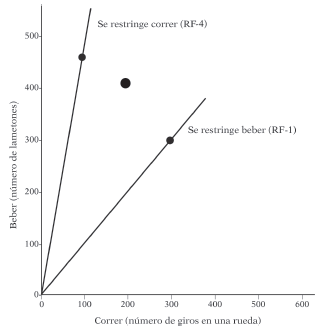

Imaginemos una situación donde a una rata se le permite el libre acceso a dos actividades, beber de una botella y correr por una rueda, y que se obtienen los resultados representados en la Figura 5.9. El punto de bienestar es dar 400 lametones y realizar 200 giros en la rueda. Beber resultaría una actividad preferida sobre correr.

Ahora se restringe la oportunidad de beber y se hace contingente a la ocurrencia previa de una cierta actividad de girar la rueda, conforme a lo estipulado por el principio de Premack. Correr sería la respuesta instrumental y beber la respuesta contingente o reforzadora, y el resultado de dicha operación de reforzamiento sería la línea A de la figura.

En concreto, se representa un programa de reforzamiento de RF-1, donde cada giro en la rueda de actividad va seguido de la emisión de un lametón a la botella con agua. Como se puede apreciar, la contingencia no pasa por el punto de bienestar, y lo que la teoría pretende determinar es cómo se ajustarán los animales a la contingencia (que se debe aceptar como supervivencial) aceptando las limitaciones impuestas por el medio. Para intentar restablecer su punto óptimo (de bienestar), el animal debe ejecutar la respuesta instrumental designada por encima del nivel que existía cuando la respuesta era irrelevante para obtener el reforzador. La frecuencia de la respuesta o su tasa se estabilizará en el punto en que el coste de incrementos mayores en la respuesta sobrepase el beneficio de obtener el reforzador lo más cerca posible del nivel alcanzado en la línea de base. Este punto es como el representado sobre la línea A porque es el que minimiza la distancia al punto de bienestar cumpliendo con la contingencia de reforzamiento. Como se puede apreciar, en este punto la actividad instrumental ha aumentado en probabilidad de ocurrencia, al tiempo que la actividad contingente ha disminuido su probabilidad, en relación con el punto de bienestar, de acuerdo también con el principio de Premack.

Si los argumentos presentados han quedado lo suficientemente claros, no debe ser difícil determinar a simple vista qué actividad es instrumental y cuál contingente en figuras como la aquí representada.

Observando el punto de bienestar y los ejes cartesianos, se puede establecer la regla de que la contingencia que se desvía en dirección opuesta a uno de los ejes desde el punto de bienestar, la actividad representada en dicho eje se restringe y por lo tanto constituye la actividad reforzadora.

La hipótesis de privación de respuesta ha sido aplicada a muchas situaciones de condicionamiento operante, resultando en predicciones relativamente novedosas y contraintuitivas. Tomemos por caso la frecuencia de reforzamiento, considerada anteriormente en relación con la ley de igualación. De acuerdo con lo allí tratado, a una mayor frecuencia de reforzamiento se debe esperar una mayor tasa de respuesta.

En otras palabras, cuanto más largo sea el intervalo entre reforzadores, la tasa de respuesta deberá ser menor. Esta función lineal negativa se desprende de forma lógica de la idea de igualación, pero también se ha obtenido con la utilización de programas básicos de reforzamiento.

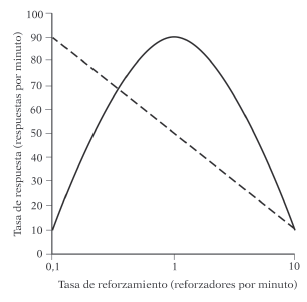

La hipótesis de privación de respuesta, sin embargo, predice que la tasa de respuesta y la tasa de reforzamiento deben relacionarse en forma de U-invertida y no de manera lineal. Específicamente, a medida que disminuya la frecuencia de reforzamiento, la tasa de respuesta instrumental debe aumentar, para posteriormente disminuir a intervalos entre reforzadores aún mayores. La Figura 5.10 ilustra como resultaría cada una de estas dos funciones.

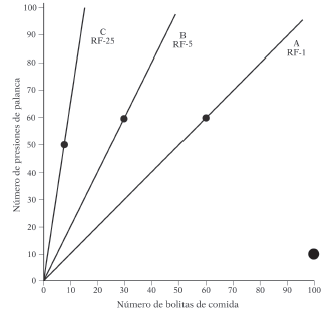

El argumento que se sigue por la hipótesis de privación de respuesta para predecir que la función debe ser bitónica es que a medida que el requerimiento del programa sea mayor (una longitud mayor del programa de razón o de intervalo), el número de respuestas debe aumentar inicialmente porque el beneficio de obtener el reforzador compensa el coste de responder más frecuentemente. Sin embargo, si el requisito del programa aumentara demasiado, el coste de responder en exceso no compensaría más la baja frecuencia de reforzamiento obtenido. Timberlake y Peden obtuvieron funciones bitónicas para los programas de IV y RF. Veamos cómo funciona la idea gráficamente para los programas de RF. La Figura 5.11 ilustra una situación experimental típica en los laboratorios de psicología del aprendizaje, una rata que tiene hambre tiene a su disposición comida y una palanca de respuestas, en condiciones de libre acceso consumirá más bolitas de comida que presionará la palanca.

Supongamos que el punto de bienestar se corresponde con la ingesta de 100 bolitas de comida y la realización de 10 presiones de palanca. Si introdujéramos ahora un programa de RF-1 por la que cada presión de palanca fuera seguida de la administración de una bola de comida, la contingencia sería como la de la línea A de la figura. Se puede calcular, como se hizo anteriormente, la distancia mínima al punto de bienestar, y así se puede predecir hasta dónde se puede forzar la respuesta instrumental de la rata de acuerdo a esa contingencia de reforzamiento. Si se alargarse el requisito de la razón, se debería reducir la frecuencia de reforzamiento, al tardarse más en completar el programa. Esto es lo que ocurre en las otras dos situaciones representadas en la figura. Un programa de RF-5 (línea B) aleja la contingencia del punto de bienestar, pero todavía existe algún punto en la contingencia donde la distancia es significativamente menor al punto de bienestar. Esto hace que el animal tenga que efectuar más presiones de palanca para acercarse lo más posible a su óptimo conductual. Cuando la frecuencia de reforzamiento disminuya más todavía y el requisito del programa se alargue en exceso, la distancia mínima desde la contingencia al punto de bienestar será grande, y, lo que es más importante, no existirá ningún área de la contingencia que sea significativamente mejor que otra. Esta es la situación que se puede producir en el ejemplo con un programa de RF-25 (línea C).

Un aspecto interesante que se deriva del análisis anterior es que la obtención de una función lineal o bitónica puede depender de la longitud de la sesión experimental, puesto que las contingencias se separan más a medida que se aumente el número de reforzadores administrados (véase la Figura 5.11). Cuando las sesiones experimentales sean relativamente cortas, como en la mayoría de los experimentos, la función que relaciona la tasa de respuesta con la tasa de reforzamiento debería tender hacia la linealidad, lo que reconcilia esta posición teórica con los resultados generalmente encontrados en investigaciones previas como las comentadas en apartados anteriores de este capítulo.